gpt-ossが登場

2025年8月7日に、GPT-5の発表がありました。

https://openai.com/ja-JP/index/introducing-gpt-5

同時期にChatGPTのモデルについてもアップデートが行われ、かなり話題になっていました。

ですが、その2日前にも重要な発表がありました。gpt-ossの発表です。

https://openai.com/ja-JP/index/introducing-gpt-oss

このモデルはノートPCでも動作可能な最先端のオープンモデルで、性能はo4-miniに匹敵するとのことです。(詳しくはこちらを参照)

パラメータ数1200億と200億の2種類(gpt-oss-120b/20b)が誰でもダウンロード可能になり、20bはほとんどのラップトップやデスクトップPCで動作する想定で、120bがハイエンド向けという位置付けです。

ローカルLLMのメリット

以前からローカルで動作するモデルについては聞いたことがありましたが、性能が最新の大規模モデルと比較して劣後しているのは明らかで、実用性という点ではあまり注目していませんでした。しかし、gpt-ossの登場で改めて考え直してみると、今後の進化によっては使いどころが出てきてもおかしくないと思うようになりました。

セキュリティ面

オフライン環境でも動作し、外部に情報を送信することがないため、ユーザーの会話データを学習に利用されないようにする設定や、機密情報を入力してはいけない(それぞれ弊社でもルール化されている)といったような、セキュリティ面の制約をほとんど気にする必要がありません。運用によっては情報漏洩のリスクを大幅に低減することが可能です。

(直近ではリコーがgpt-oss環境の提供を開始したというニュースもありました)

コスト面

APIをコールするコストが不要なので、例えばAIアプリをローカルで構築するような用途だと圧倒的に費用を抑えられます。

AIにアクセスするエンドポイントをローカルに置き換える等も可能になるため、AIアプリのローカル開発環境を作る場合にも向いています。(現状は性能差があるのでこの用途では微妙かもしれません)

カスタマイズ性・拡張性

社内データを使ったカスタマイズや、クラウドサービスの規約上実現が難しいコンテンツへの対応等

このあたりがメリットとして挙がります。gpt-ossを皮切りに、一気に性能が上がっていくことも考えられるため、段階的に実用性が上がっていきそうです。

導入について

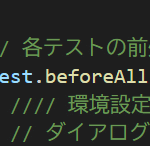

ローカルLLMに関する導入や環境構築の情報はネット上にも豊富にあり割愛しますが、LM Studioが最も手軽で簡単です。

私も個人の環境でLM Studioを導入⇒gpt-ossをインストール⇒簡易的なAIチャットアプリをPythonで作成という流れを実施してみたのですが、30分ほどで動くものを作成できました。様々手段がありますが、軽く触るのであればLM Studioが最も直感的で簡単です。

今後について

個人的には、個人開発で使用するのが面白そうだと感じました。

社内アプリへの活用という点でも将来的には選択肢に挙がるかもしれません。

今回は簡単な紹介としましたが、独自の事例等が作れれば別の機会に共有します。